- CHAMPS (THÉORIE DES)

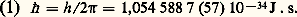

- CHAMPS (THÉORIE DES)La théorie des champs étudie la dynamique des systèmes à un nombre infini de degrés de liberté. Elle trouve son origine dans l’électromagnétisme et s’est développée en intégrant mécanique quantique et relativité. Après en avoir suivi l’évolution, nous décrirons succinctement la formulation actuelle. Le lecteur aura intérêt à consulter les articles mécanique QUANTIQUE, électrodynamique QUANTIQUE, PARTICULES ÉLÉMENTAIRES, et les références pour des compléments.1. HistoriqueAu cours du XIXe siècle, les électrodynamiciens, à la suite de Faraday, ont élaboré les concepts de champ électrique et magnétique en étudiant les forces sur un corps d’épreuve infinitésimal. James Clerk Maxwell en résume et complète les lois empiriques sous forme différentielle. Heinrich Hertz met en évidence les ondes électromagnétiques porteuses d’énergie, d’impulsion et de moment cinétique, achevant ainsi la synthèse avec l’optique. Les champs ont acquis un statut indépendant et ne sont plus considérés comme des outils intermédiaires. À l’aube du XXe siècle, Hendrick Antoon Lorentz et Henri Poincaré, puis Albert Einstein, découvrent la structure invariante relativiste des équations de Maxwell. Il en résulte une profonde modification de la conception de l’espace et du temps, auxquels les physiciens avaient désespérément tenté de conférer, sous le nom d’éther, des propriétés mécaniques, pour pouvoir considérer les ondes électromagnétiques comme les vibrations d’un milieu matériel. Cette évolution est couronnée par la théorie géométrique de la gravitation, due à Einstein en 1917. Les équations auxquelles il parvient, dont la forme présente des analogies avec celles de Maxwell, ouvrent la voie à des tentatives d’unification qui se poursuivent encore aujourd’hui.Cependant, une découverte fondamentale ébranle l’édifice de la physique classique. Le rayonnement d’un corps porté à une température uniforme défiait les lois de l’électromagnétisme et de la thermodynamique. En 1900, Max Planck ajuste empiriquement le spectre observé à l’aide d’une constante, h , dont la dimension est celle d’une action: énergie multipliée par un temps ou bien impulsion multipliée par une longueur. On préfère utiliser aujourd’hui:

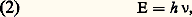

Planck en donne une première interprétation en considérant que l’énergie (E) est concentrée sous forme de grains, les quanta, reliée à la fréquence ( 益) par la formule:

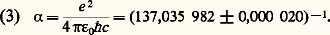

Planck en donne une première interprétation en considérant que l’énergie (E) est concentrée sous forme de grains, les quanta, reliée à la fréquence ( 益) par la formule: confirmée par la théorie de l’effet photo-électrique (Einstein, 1904). Tandis que la mécanique des quanta s’applique à la structure atomique dont elle permet de comprendre les spectres discrets d’émission et d’absorption et conduit au modèle de Niels Bohr (1911), la révolution ainsi amorçée ne parvient que lentement à maturité en ce qui concerne le champ électromagnétique. Les discontinuités quantiques semblent, un temps, pouvoir être confinées aux processus d’émission et d’absorption par les atomes, sans que le champ de Maxwell en soit directement affecté. Ce modèle semi-classique conserve encore son intérêt, en particulier en optique quantique.La mécanique quantique achève sa formalisation aux alentours des années 1924-1925 sous l’impulsion de Louis de Broglie, Werner Karl Heisenberg, Pascual Jordan et Erwin Schrödinger. Elle implique un changement radical dans la description des systèmes mécaniques. Son interprétation probabiliste, proposée par Bohr, soulève à l’origine des controverses philosophiques et épistémologiques. Les états d’un système sont représentés par les vecteurs normalisables d’un espace de Hilbert (cf. espace de HILBERT). Les mesures portent sur des transitions entre états, dont la probabilité est donnée par le carré du module du produit scalaire des vecteurs correspondants. La nouveauté de ces conceptions, qui heurtent un mode de pensée modelé par des siècles de construction d’une physique macroscopique, explique en partie les objections formulées par certains des fondateurs, parmi lesquels Einstein et Schrodinger. Mais très rapidement les succès de la physique quantique rallièrent la très grande majorité des scientifiques. La structure atomique, la liaison chimique, les propriétés de la matière condensée et des solides, le magnétisme, la physique des basses températures, marquée d’effets spectaculaires comme la superfluidité de l’hélium liquide ou la supraconductivité de certains métaux, pour ne citer que quelques exemples, sont incompréhensibles sans un appel à la mécanique quantique.Dans le domaine de la physique microscopique, l’hypothèse atomique des anciens a trouvé sa justification dans l’œuvre des chimistes du XIXe siècle, et le tableau de Mendeleev met en évidence la structure périodique des atomes (1871). La découverte de l’électron dans les rayons cathodiques par Joseph John Thomson (1897) révèle l’un des constitutuants fondamentaux de la matière. La conception de l’édifice atomique est bouleversée par la mise en évidence du noyau (Ernest Rutherford, 1911).Lorentz élabore un modèle classique de l’électron en interaction avec le champ électromagnétique. Les effets d’auto-interaction font apparaître une contribution à la masse qui devient infinie à la limite d’une charge ponctuelle, ainsi que des corrections pour tenir compte des transferts d’énergie et d’impulsion lors du rayonnement. Ces termes faisant appel à des dérivées troisièmes dans le temps sont à l’origine d’effets qui, pris à la lettre, c’est-à-dire hors du domaine de validité de la physique classique, semblent en contradiction avec les principes de localité et causalité; existence d’auto- ou de pré-accélérations. Inutile de dire que de tels phénomènes ne peuvent être observés. L’échelle des distances qui les caractérise est le rayon classique de l’électron r e = e 2/4 神﨎0mc 2 = 2,8 10-13 cm, alors qu’ils sont masqués par des effets quantiques intervenant à l’échelle de la longueur d’onde Compton de l’électron /c = 寮/mc = 3,9 10-11 cm au-delà de laquelle la conception classique d’une charge ponctuelle perd son sens (cf. électrodynamique QUANTIQUE). Le rapport de ces deux longueurs est une quantité fondamentale de l’électrodynamique quantique, la constante de structure fine 見 donnée par:

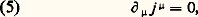

confirmée par la théorie de l’effet photo-électrique (Einstein, 1904). Tandis que la mécanique des quanta s’applique à la structure atomique dont elle permet de comprendre les spectres discrets d’émission et d’absorption et conduit au modèle de Niels Bohr (1911), la révolution ainsi amorçée ne parvient que lentement à maturité en ce qui concerne le champ électromagnétique. Les discontinuités quantiques semblent, un temps, pouvoir être confinées aux processus d’émission et d’absorption par les atomes, sans que le champ de Maxwell en soit directement affecté. Ce modèle semi-classique conserve encore son intérêt, en particulier en optique quantique.La mécanique quantique achève sa formalisation aux alentours des années 1924-1925 sous l’impulsion de Louis de Broglie, Werner Karl Heisenberg, Pascual Jordan et Erwin Schrödinger. Elle implique un changement radical dans la description des systèmes mécaniques. Son interprétation probabiliste, proposée par Bohr, soulève à l’origine des controverses philosophiques et épistémologiques. Les états d’un système sont représentés par les vecteurs normalisables d’un espace de Hilbert (cf. espace de HILBERT). Les mesures portent sur des transitions entre états, dont la probabilité est donnée par le carré du module du produit scalaire des vecteurs correspondants. La nouveauté de ces conceptions, qui heurtent un mode de pensée modelé par des siècles de construction d’une physique macroscopique, explique en partie les objections formulées par certains des fondateurs, parmi lesquels Einstein et Schrodinger. Mais très rapidement les succès de la physique quantique rallièrent la très grande majorité des scientifiques. La structure atomique, la liaison chimique, les propriétés de la matière condensée et des solides, le magnétisme, la physique des basses températures, marquée d’effets spectaculaires comme la superfluidité de l’hélium liquide ou la supraconductivité de certains métaux, pour ne citer que quelques exemples, sont incompréhensibles sans un appel à la mécanique quantique.Dans le domaine de la physique microscopique, l’hypothèse atomique des anciens a trouvé sa justification dans l’œuvre des chimistes du XIXe siècle, et le tableau de Mendeleev met en évidence la structure périodique des atomes (1871). La découverte de l’électron dans les rayons cathodiques par Joseph John Thomson (1897) révèle l’un des constitutuants fondamentaux de la matière. La conception de l’édifice atomique est bouleversée par la mise en évidence du noyau (Ernest Rutherford, 1911).Lorentz élabore un modèle classique de l’électron en interaction avec le champ électromagnétique. Les effets d’auto-interaction font apparaître une contribution à la masse qui devient infinie à la limite d’une charge ponctuelle, ainsi que des corrections pour tenir compte des transferts d’énergie et d’impulsion lors du rayonnement. Ces termes faisant appel à des dérivées troisièmes dans le temps sont à l’origine d’effets qui, pris à la lettre, c’est-à-dire hors du domaine de validité de la physique classique, semblent en contradiction avec les principes de localité et causalité; existence d’auto- ou de pré-accélérations. Inutile de dire que de tels phénomènes ne peuvent être observés. L’échelle des distances qui les caractérise est le rayon classique de l’électron r e = e 2/4 神﨎0mc 2 = 2,8 10-13 cm, alors qu’ils sont masqués par des effets quantiques intervenant à l’échelle de la longueur d’onde Compton de l’électron /c = 寮/mc = 3,9 10-11 cm au-delà de laquelle la conception classique d’une charge ponctuelle perd son sens (cf. électrodynamique QUANTIQUE). Le rapport de ces deux longueurs est une quantité fondamentale de l’électrodynamique quantique, la constante de structure fine 見 donnée par: La construction des théories quantiques des champs peut se subdiviser en trois étapes:– la formulation, du milieu des années vingt à l’immédiat après-guerre;– la renormalisation, de la fin des années quarante à la fin des années soixante;– l’élaboration, dans la période la plus récente.FormulationUne première période voit le développement de l’électrodynamique quantique. Il s’agit d’abord de la quantification du champ lui-même avec des contributions de Paul Dirac (1927), Heisenberg, Jordan et Wolfgang Pauli (1928-1930) et Enrico Fermi (1932), qui ont à surmonter les difficiles questions d’invariance de jauge et d’invariance relativiste. Ils obtiennent une description des états en termes de photons, particules de masse nulle et d’hélicité 梁寮 (l’hélicité est la composante du moment cinétique dans la direction du mouvement). Victor F. Weisskopf et Eugène Paul Wigner étudient la largeur naturelle des raies et observent l’apparition de quantités infinies dans les déplacements de niveaux. En 1928, Dirac propose une généralisation relativiste de l’équation de Schrodinger et réinterprète les niveaux d’énergie négative en utilisant le principe d’exclusion de Pauli. Ces niveaux sont tous occupés dans l’état fondamental, et il faut fournir une énergie supérieure ou égale à 2 mc 2 pour créer une paire de particules de charges opposées, dont l’une s’interprète comme une vacance parmi les états d’énergie négative. Après un premier essai d’identification des particules chargées positivement avec les protons, Carl David Anderson découvre en 1932 le positron, l’antiparticule de l’électron. L’idée se fait jour qu’une théorie correcte des particules chargées nécessite la quantification (on disait seconde quantification) du champ de Dirac, qui ne peut pas s’interpréter comme une fonction d’onde. Pour satisfaire au principe d’exclusion, ce champ nécessite l’introduction d’opérateurs anticommutants. Ainsi se dégage la notion de statistique quantique, selon que les états sont totalement symétriques (Bose-Einstein) ou antisymétriques (Fermi-Dirac). On entreprend l’investigation de champs de types variés. Le champ scalaire de Oscar Klein et Gordon est quantifié par Pauli et Weisskopf et on étudie le cas de spins plus élevés. Markus Fierz et Pauli vers 1940 clarifient la relation entre spin et statistique, en montrant que les exigences de localité et d’invariance relativiste entraînent que les particules de spin entier sont des bosons, celles de spin demi-entier des fermions.Malgré les quantités infinies rencontrées dans des calculs perturbatifs encore extrêmement complexes, et qui doivent être soustraites selon des recettes qui dépendent du phénomène à étudier, les physiciens parviennent à prédire un grand nombre d’effets. Citons le calcul de la diffusion Compton (Klein et Y. Nishina), la modification du potentiel coulombien à courte distance due à la polarisation du vide (Edwin A. Uehling), etc. Les non-linéarités dans la propagation du rayonnement induites par les corrections quantiques sont caractérisées par H. Euler et Heisenberg. En 1937, Felix Bloch et A. Nordsieck analysent l’origine classique des divergences infrarouges dues à la masse nulle des photons.Malgré les succès incontestables qui marquent cette époque, certains physiciens, dont Pauli, demeurent très insatisfaits de l’apparition des divergences ultraviolettes et pensent que les idées radicalement nouvelles sont nécessaires pour les maîtriser. Les premiers essais pour étendre le domaine de validité de la théorie des champs aux interactions fortes révèlent à leur tour la nécessité d’étudier des problèmes de couplage fort.RenormalisationL’immédiat après-guerre voit le développement systématique d’une série perturbative en puissance de 見, invariante relativiste, œuvre de Sin-Itiro Tomonaga, Julian Schwinger, Richard P. Feynman et Freeman J. Dyson. La renormalisation des divergences ultraviolettes permet de nombreuses prédictions concernant les corrections radiatives aux niveaux et transitions atomiques (effet Lamb, structure hyperfine, moment magnétique anormal de l’électron, positronium...) ainsi que le calcul des processus de diffusion électromagnétique. Des expériences d’une très grande finesse confirment pleinement ces prédictions. Il s’ensuit un foisonnement de résultats théoriques et expérimentaux qui confirment la validité de l’électrodynamique quantique à un niveau de précision sans précédent.L’extension de ces méthodes aux autres types d’interaction semble se heurter à de graves obstacles. Il s’agit d’une part de la théorie des interactions faibles, proposée par Fermi, pour rendre compte de la désintégration 廓 des noyaux, où un neutron se transforme en proton accompagné d’une paire chargée «électron-neutrino». Bien que l’étude de ce modèle soit couronnée en 1957 par la découverte de la violation de l’invariance par parité, suggérée par Tsung-Dao Lee et Chen-Ning Yang et mise en évidence par Chien-Shiung Wu, les théoriciens s’inquiètent de ses fondements. Ils prévoient que de sérieuses modifications devront lui être apportées à des énergies de l’ordre de la centaine de GeV (1 GeV = 109 eV).Les difficultés sont encore plus grandes en ce qui concerne les interactions fortes responsables de la cohésion nucléaire. Dès 1935, Hideki Yukawa avait prédit l’existence d’une particule légère, baptisée meson pi (ou pion ), médiateur de ces interactions, et finalement observée par Cecil Frank Powell en 1947. Cette découverte marque le début d’une longue liste de particules et résonances mises en évidence grâce à la construction d’accélérateurs de plus en plus puissants. Des faisceaux de particules très énergétiques permettent d’explorer des cibles sur des échelles spatio-temporelles de plus en plus courtes. Dès la fin des années cinquante, il fut établi que les constantes de couplage correspondantes sont de l’ordre de l’unité. Par exemple, dans le cas de la diffusion pion-nucléon (le nucléon regroupe proton et neutron en un doublet dont les interactions fortes sont similaires), cette constante est de l’ordre de 14,6. Cela exclut d’envisager un développement perturbatif. Dans l’incapacité de trouver une issue à ces problèmes, les théoriciens des champs durent alors faire un retour sur les sources et les concepts. Ils cherchèrent à élaborer une axiomatique (Arthur S. Wightman) qui permette d’extraire des conclusions générales résultant d’une dynamique quantique, locale, relativiste. Au nombre des résultats, il faut compter, d’une part, une preuve de la relation entre spin et statistique, et, d’autre part, l’invariance sous l’effet du produit de l’inversion d’espace (P), de temps (T) et de conjugaison de charge (C). Des recherches ardues furent entreprises sur les propriétés d’analyticité des amplitudes de diffusion, ainsi que sur des procédés constructifs de théories des champs (James Glimm, Arthur Jaffe). Par ailleurs, le formalisme de la renormalisation était systématisé par Bogolioubov et de nombreux théoriciens.ÉlaborationUne dernière période s’ouvre, à la fin des années soixante, avec la proposition par Sheldon Lee Glashow, Steven Weinberg et Abdus Salam d’une théorie unifiée et renormalisable des interactions électromagnétiques et faibles. La découverte des « courants neutres», ne mettant pas en jeu de transfert de charge, conformément aux prédictions, en a constitué la première confirmation, tandis que de nombreuses expériences sont en préparation pour en explorer les conséquences à plus haute énergie. Le modèle met en jeu des champs de jauge non abéliens, introduits par Chan Ning Yang et Robert Mills en 1954, dont la quantification (Feynman, Brice De Witt, Ludwig Faddeev) et la renormalisation (’t Hooft) posent de délicats problèmes.L’étude des diffusions très inélastiques à haute énergie et la mise en évidence de résonances étroites de masse élevée conduisent à l’élaboration d’une théorie de la structure de la matière en termes de constituants de charge fractionnaire, les quarks, interagissant faiblement à courte distance, mais confinés de manière permanente, non directement observables par un détecteur dans les particules hadroniques, mesons et baryons. La théorie de ces interactions, ou chromodynamique, rend compte de ces propriétés, en faisant de nouveau appel à un champ de jauge non abélien dont les quanta ou gluons ne sont pas directement observables. L’étude théorique en est vigoureusement poursuivie à l’heure actuelle, particulièrement dans le domaine du couplage fort nécessaire pour décrire le spectre de basse énergie.L’extension des méthodes de la théorie des champs en mécanique statistique et physique de la matière condensée est illustrée par l’application du groupe de renormalisation (Murray Gell-Mann, Francis Low, Curtis Callan, Curt Symanzik) à l’étude du domaine critique observé dans les transitions de phase continues. Wilson met en évidence la parenté de ces sujets et, à sa suite, les physiciens s’emploient à calculer les indices critiques, relatifs aux différentes observables, chaleur spécifique, longueurs de corrélation, aimantation... Parallèlement, on découvre un certain nombre de modèles bidimensionnels solubles qui fournissent des exemples sur lesquels on peut examiner différentes méthodes et hypothèses.La prédiction théorique par Stephen W. Hawking du spectre des trous noirs (1974) ouvre la voie d’une interpénétration entre physique quantique et gravitation. Une intense activité se déploie qui vise à unifier toutes les interactions, y compris peut être la gravitation, dans une théorie synthétique dont l’échelle caractéristique serait voisine de la masse de Planck de l’ordre de 1019 GeV/c 2. Une des conséquences observables en serait la désintégration du proton (non observée jusqu’à maintenant). Un candidat à une telle unification est la théorie des cordes quantiques (Polyakov, Green, Schwarz et Witten) qui a soulevé de grands espoirs dans les années quatre-vingt.2. Formalisme et propriétés principalesLagrangien et invariancesNous allons décrire brièvement la théorie lagrangienne des champs. Classique ou quantique, elle relève d’un principe de moindre action, qui exprime que l’intégrale d’une densité, le lagrangien L, fonction des champs, dénotés collectivement 﨏, et de leurs dérivées 煉 size=1猪 﨏 令 煉 﨏/ 煉x size=1猪, est stationnaire pour des conditions aux limites appropriées. On obtient ainsi les formules d’Euler-Lagrange:

La construction des théories quantiques des champs peut se subdiviser en trois étapes:– la formulation, du milieu des années vingt à l’immédiat après-guerre;– la renormalisation, de la fin des années quarante à la fin des années soixante;– l’élaboration, dans la période la plus récente.FormulationUne première période voit le développement de l’électrodynamique quantique. Il s’agit d’abord de la quantification du champ lui-même avec des contributions de Paul Dirac (1927), Heisenberg, Jordan et Wolfgang Pauli (1928-1930) et Enrico Fermi (1932), qui ont à surmonter les difficiles questions d’invariance de jauge et d’invariance relativiste. Ils obtiennent une description des états en termes de photons, particules de masse nulle et d’hélicité 梁寮 (l’hélicité est la composante du moment cinétique dans la direction du mouvement). Victor F. Weisskopf et Eugène Paul Wigner étudient la largeur naturelle des raies et observent l’apparition de quantités infinies dans les déplacements de niveaux. En 1928, Dirac propose une généralisation relativiste de l’équation de Schrodinger et réinterprète les niveaux d’énergie négative en utilisant le principe d’exclusion de Pauli. Ces niveaux sont tous occupés dans l’état fondamental, et il faut fournir une énergie supérieure ou égale à 2 mc 2 pour créer une paire de particules de charges opposées, dont l’une s’interprète comme une vacance parmi les états d’énergie négative. Après un premier essai d’identification des particules chargées positivement avec les protons, Carl David Anderson découvre en 1932 le positron, l’antiparticule de l’électron. L’idée se fait jour qu’une théorie correcte des particules chargées nécessite la quantification (on disait seconde quantification) du champ de Dirac, qui ne peut pas s’interpréter comme une fonction d’onde. Pour satisfaire au principe d’exclusion, ce champ nécessite l’introduction d’opérateurs anticommutants. Ainsi se dégage la notion de statistique quantique, selon que les états sont totalement symétriques (Bose-Einstein) ou antisymétriques (Fermi-Dirac). On entreprend l’investigation de champs de types variés. Le champ scalaire de Oscar Klein et Gordon est quantifié par Pauli et Weisskopf et on étudie le cas de spins plus élevés. Markus Fierz et Pauli vers 1940 clarifient la relation entre spin et statistique, en montrant que les exigences de localité et d’invariance relativiste entraînent que les particules de spin entier sont des bosons, celles de spin demi-entier des fermions.Malgré les quantités infinies rencontrées dans des calculs perturbatifs encore extrêmement complexes, et qui doivent être soustraites selon des recettes qui dépendent du phénomène à étudier, les physiciens parviennent à prédire un grand nombre d’effets. Citons le calcul de la diffusion Compton (Klein et Y. Nishina), la modification du potentiel coulombien à courte distance due à la polarisation du vide (Edwin A. Uehling), etc. Les non-linéarités dans la propagation du rayonnement induites par les corrections quantiques sont caractérisées par H. Euler et Heisenberg. En 1937, Felix Bloch et A. Nordsieck analysent l’origine classique des divergences infrarouges dues à la masse nulle des photons.Malgré les succès incontestables qui marquent cette époque, certains physiciens, dont Pauli, demeurent très insatisfaits de l’apparition des divergences ultraviolettes et pensent que les idées radicalement nouvelles sont nécessaires pour les maîtriser. Les premiers essais pour étendre le domaine de validité de la théorie des champs aux interactions fortes révèlent à leur tour la nécessité d’étudier des problèmes de couplage fort.RenormalisationL’immédiat après-guerre voit le développement systématique d’une série perturbative en puissance de 見, invariante relativiste, œuvre de Sin-Itiro Tomonaga, Julian Schwinger, Richard P. Feynman et Freeman J. Dyson. La renormalisation des divergences ultraviolettes permet de nombreuses prédictions concernant les corrections radiatives aux niveaux et transitions atomiques (effet Lamb, structure hyperfine, moment magnétique anormal de l’électron, positronium...) ainsi que le calcul des processus de diffusion électromagnétique. Des expériences d’une très grande finesse confirment pleinement ces prédictions. Il s’ensuit un foisonnement de résultats théoriques et expérimentaux qui confirment la validité de l’électrodynamique quantique à un niveau de précision sans précédent.L’extension de ces méthodes aux autres types d’interaction semble se heurter à de graves obstacles. Il s’agit d’une part de la théorie des interactions faibles, proposée par Fermi, pour rendre compte de la désintégration 廓 des noyaux, où un neutron se transforme en proton accompagné d’une paire chargée «électron-neutrino». Bien que l’étude de ce modèle soit couronnée en 1957 par la découverte de la violation de l’invariance par parité, suggérée par Tsung-Dao Lee et Chen-Ning Yang et mise en évidence par Chien-Shiung Wu, les théoriciens s’inquiètent de ses fondements. Ils prévoient que de sérieuses modifications devront lui être apportées à des énergies de l’ordre de la centaine de GeV (1 GeV = 109 eV).Les difficultés sont encore plus grandes en ce qui concerne les interactions fortes responsables de la cohésion nucléaire. Dès 1935, Hideki Yukawa avait prédit l’existence d’une particule légère, baptisée meson pi (ou pion ), médiateur de ces interactions, et finalement observée par Cecil Frank Powell en 1947. Cette découverte marque le début d’une longue liste de particules et résonances mises en évidence grâce à la construction d’accélérateurs de plus en plus puissants. Des faisceaux de particules très énergétiques permettent d’explorer des cibles sur des échelles spatio-temporelles de plus en plus courtes. Dès la fin des années cinquante, il fut établi que les constantes de couplage correspondantes sont de l’ordre de l’unité. Par exemple, dans le cas de la diffusion pion-nucléon (le nucléon regroupe proton et neutron en un doublet dont les interactions fortes sont similaires), cette constante est de l’ordre de 14,6. Cela exclut d’envisager un développement perturbatif. Dans l’incapacité de trouver une issue à ces problèmes, les théoriciens des champs durent alors faire un retour sur les sources et les concepts. Ils cherchèrent à élaborer une axiomatique (Arthur S. Wightman) qui permette d’extraire des conclusions générales résultant d’une dynamique quantique, locale, relativiste. Au nombre des résultats, il faut compter, d’une part, une preuve de la relation entre spin et statistique, et, d’autre part, l’invariance sous l’effet du produit de l’inversion d’espace (P), de temps (T) et de conjugaison de charge (C). Des recherches ardues furent entreprises sur les propriétés d’analyticité des amplitudes de diffusion, ainsi que sur des procédés constructifs de théories des champs (James Glimm, Arthur Jaffe). Par ailleurs, le formalisme de la renormalisation était systématisé par Bogolioubov et de nombreux théoriciens.ÉlaborationUne dernière période s’ouvre, à la fin des années soixante, avec la proposition par Sheldon Lee Glashow, Steven Weinberg et Abdus Salam d’une théorie unifiée et renormalisable des interactions électromagnétiques et faibles. La découverte des « courants neutres», ne mettant pas en jeu de transfert de charge, conformément aux prédictions, en a constitué la première confirmation, tandis que de nombreuses expériences sont en préparation pour en explorer les conséquences à plus haute énergie. Le modèle met en jeu des champs de jauge non abéliens, introduits par Chan Ning Yang et Robert Mills en 1954, dont la quantification (Feynman, Brice De Witt, Ludwig Faddeev) et la renormalisation (’t Hooft) posent de délicats problèmes.L’étude des diffusions très inélastiques à haute énergie et la mise en évidence de résonances étroites de masse élevée conduisent à l’élaboration d’une théorie de la structure de la matière en termes de constituants de charge fractionnaire, les quarks, interagissant faiblement à courte distance, mais confinés de manière permanente, non directement observables par un détecteur dans les particules hadroniques, mesons et baryons. La théorie de ces interactions, ou chromodynamique, rend compte de ces propriétés, en faisant de nouveau appel à un champ de jauge non abélien dont les quanta ou gluons ne sont pas directement observables. L’étude théorique en est vigoureusement poursuivie à l’heure actuelle, particulièrement dans le domaine du couplage fort nécessaire pour décrire le spectre de basse énergie.L’extension des méthodes de la théorie des champs en mécanique statistique et physique de la matière condensée est illustrée par l’application du groupe de renormalisation (Murray Gell-Mann, Francis Low, Curtis Callan, Curt Symanzik) à l’étude du domaine critique observé dans les transitions de phase continues. Wilson met en évidence la parenté de ces sujets et, à sa suite, les physiciens s’emploient à calculer les indices critiques, relatifs aux différentes observables, chaleur spécifique, longueurs de corrélation, aimantation... Parallèlement, on découvre un certain nombre de modèles bidimensionnels solubles qui fournissent des exemples sur lesquels on peut examiner différentes méthodes et hypothèses.La prédiction théorique par Stephen W. Hawking du spectre des trous noirs (1974) ouvre la voie d’une interpénétration entre physique quantique et gravitation. Une intense activité se déploie qui vise à unifier toutes les interactions, y compris peut être la gravitation, dans une théorie synthétique dont l’échelle caractéristique serait voisine de la masse de Planck de l’ordre de 1019 GeV/c 2. Une des conséquences observables en serait la désintégration du proton (non observée jusqu’à maintenant). Un candidat à une telle unification est la théorie des cordes quantiques (Polyakov, Green, Schwarz et Witten) qui a soulevé de grands espoirs dans les années quatre-vingt.2. Formalisme et propriétés principalesLagrangien et invariancesNous allons décrire brièvement la théorie lagrangienne des champs. Classique ou quantique, elle relève d’un principe de moindre action, qui exprime que l’intégrale d’une densité, le lagrangien L, fonction des champs, dénotés collectivement 﨏, et de leurs dérivées 煉 size=1猪 﨏 令 煉 﨏/ 煉x size=1猪, est stationnaire pour des conditions aux limites appropriées. On obtient ainsi les formules d’Euler-Lagrange: Dans le cas électromagnétique, les équations variationnelles s’identifient aux équations de Maxwell.À tout groupe d’invariance continu du lagrangien, le théorème de Noether associe un courant conservé j size=1猪, c’est-à-dire tel que:

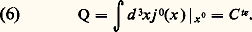

Dans le cas électromagnétique, les équations variationnelles s’identifient aux équations de Maxwell.À tout groupe d’invariance continu du lagrangien, le théorème de Noether associe un courant conservé j size=1猪, c’est-à-dire tel que: permettant d’obtenir par intégration une quantité invariante:

permettant d’obtenir par intégration une quantité invariante: L’invariance sous les translations, rotations et transformations de Lorentz permet de définir des quantités conservées: l’impulsion, l’énergie et le moment angulaire. Les quantités (ou charges) conservées engendrent les transformations infinitésimales des variables dynamiques en formant des crochets de Poisson dans le cadre classique, ou des commutateurs, dans le cadre quantique. Dans ce cas, on doit avoir:

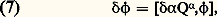

L’invariance sous les translations, rotations et transformations de Lorentz permet de définir des quantités conservées: l’impulsion, l’énergie et le moment angulaire. Les quantités (ou charges) conservées engendrent les transformations infinitésimales des variables dynamiques en formant des crochets de Poisson dans le cadre classique, ou des commutateurs, dans le cadre quantique. Dans ce cas, on doit avoir: ce qui impose des contraintes sur l’algèbre des champs. En pratique, pour les champs de moment cinétique (spin) entier, les relations de commutation à temps égaux (x 0) prennent la forme:

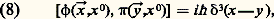

ce qui impose des contraintes sur l’algèbre des champs. En pratique, pour les champs de moment cinétique (spin) entier, les relations de commutation à temps égaux (x 0) prennent la forme: où:

où: est le champ conjugué de 﨏. Ces relations sont remplacées par des anticommutations (le commutateur de deux opérateurs A et B est [A, B] = AB 漣 BA, l’anticommutateur estA, B = AB + BA) pour les champs de spin demi-entier, comme le champ électron-positron, si l’on veut conserver le caractère local des interactions dans le cadre d’un modèle invariant relativiste (théorème spin-statistique). Le cas le plus simple est celui d’un lagrangien quadratique, comme celui du champ électromagnétique en l’absence de sources. Développant les champs sur une base des solutions des équations classiques (dans ce cas linéaire), l’hamiltonien, générateur des translations temporelles, prend la forme:

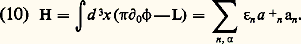

est le champ conjugué de 﨏. Ces relations sont remplacées par des anticommutations (le commutateur de deux opérateurs A et B est [A, B] = AB 漣 BA, l’anticommutateur estA, B = AB + BA) pour les champs de spin demi-entier, comme le champ électron-positron, si l’on veut conserver le caractère local des interactions dans le cadre d’un modèle invariant relativiste (théorème spin-statistique). Le cas le plus simple est celui d’un lagrangien quadratique, comme celui du champ électromagnétique en l’absence de sources. Développant les champs sur une base des solutions des équations classiques (dans ce cas linéaire), l’hamiltonien, générateur des translations temporelles, prend la forme: Les opérateurs a n et a +n détruisent et créent un quantum d’énergie 﨎n (omettant le détail des nombres quantiques), et les 﨎n sont tous positifs de manière à assurer l’existence d’un état fondamental, ou vide, noté |0 礪, d’énergie nulle et tel que:

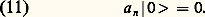

Les opérateurs a n et a +n détruisent et créent un quantum d’énergie 﨎n (omettant le détail des nombres quantiques), et les 﨎n sont tous positifs de manière à assurer l’existence d’un état fondamental, ou vide, noté |0 礪, d’énergie nulle et tel que: Le champ est susceptible de créer des particules correspondant aux solutions de fréquence positive des équations classiques ou d’en absorber ce qui correspond aux solutions de fréquence négative.Sous l’effet des interactions, les quanta ou particules peuvent être créés ou détruits, ou encore leur état interne modifié. Ces effets sont induits dans le lagrangien par des termes de degré supérieur à deux, soit symboliquement g .LI( 﨏). Dans un processus typique de diffusion, on peut imaginer que le rôle des interactions est négligeable longtemps avant ou après les collisions (théorie asymptotique de Harry Lehmann, Kurt Symanzik et Wolfgang Zimmermann). On utilise alors un formalisme, dit représentation d’interaction, dans lequel on donne aux opérateurs une évolution dictée par le lagrangien libre. L’amplitude de probabilité de transition entre un état entrant |in 礪 et sortant |out 礪, caractérisés entre autres par des ensembles de quadri-impulsionp, peut alors s’exprimer à l’aide de fonctions de Green dont l’étude est l’objet central de la théorie. D’une part, il est possible de chercher à exploiter leurs propriétés générales découlant de l’invariance relativiste, la causalité, c’est-à-dire la commutativité des observables pour des séparations du genre espace, l’unitarité ou conservation des probabilités et l’existence (ou l’absence) d’une énergie minimale non nulle pour les états distincts du vide. C’est le but de l’approche axiomatique qui aboutit à prouver des propriétés d’analyticité des amplitudes dans l’espace des impulsions. D’autre part, on peut procéder à un développement systématique dans la (les) constante(s) de couplage g .Développement perturbatif et renormalisationCe développement fait apparaître une série infinie de termes dont il est possible de donner une représentation par des diagrammes dus à Feynman. Chaque ligne porteuse d’une impulsion p est associée à un propagateur, et chaque vertex à une interaction comportant une constante de couplage et un facteur exprimant la conservation des quadriimpulsions. À impulsions externes fixées, il s’agit alors d’intégrer sur les impulsions internes restant indéterminées. Les termes correspondant à des diagrammes sans circuits fermés (diagrammes en arbres) sont dits termes de Born (termes de premier ordre) et leur évaluation ne pose pas de problèmes. En revanche, les contributions des termes plus élevés font en général apparaître des divergences pour les valeurs infinies des moments internes, qui sont dites ultraviolettes en souvenir des difficultés ultraviolettes dans le spectre du corps noir. L’origine de ces divergences tient au caractère singulier des propagateurs et à l’existence de couplages locaux, c’est-à-dire n’impliquant pas de structure interne dans une théorie fondamentale. En électrodynamique, par exemple, aucun signe d’une telle sous-structure n’a pu être mis en évidence jusqu’à des distances inférieures au millième de la taille des noyaux.Pour donner un sens à la série perturbative, il est donc nécessaire de trouver des prescriptions de soustraction qui conduisent à des intégrales bien définies. C’est un des triomphes de la théorie d’être parvenu à définir un schéma unique et cohérent de soustraction qui élimine les quantités apparemment infinies au profit d’observables, masses et charges des particules, et d’une redéfinition des champs au moyen de facteurs multiplicatifs. Ce processus est appelé renormalisation, et les modèles auxquels il s’applique sont dits renormalisables. En pratique, la méthode consiste à introduire à un stade intermédiaire une régularisation, caractérisée par un facteur de coupure 炙 ayant la dimension d’une énergie, et beaucoup plus grand que toutes les énergies mises en jeu dans le processus étudié. On classe alors le degré de divergence potentiel d’une contribution représentée par un diagramme ou sous-diagramme, et on caractérise les amplitudes primitivement divergentes. Dans une théorie renormalisable, ces amplitudes sont en nombre fini et, après soustraction, leurs divergences sont absorbées dans des quantités mesurables correspondantes. Bien entendu, la renormalisation préserve les propriétés fondamentales, en particulier l’invariance relativiste, et conduit à des expressions finies, bien que parfois malcommodes à évaluer. Pour donner une idée de cette complexité, mentionnons un calcul du moment anormal de l’électron à l’ordre 見4. Le nombre des diagrammes est de 891, et les amplitudes associées requièrent soustractions, intégrations multiples et manipulations algébriques.Une remarque importante due originellement à E.C.G. Stueckelberg et Alexander L. Peterman (1953) et à Gell-Mann et Low (1954) concerne l’existence d’un groupe de transformations, dit groupe de renormalisation. Il tire son origine de la possibilité d’effectuer les opérations de soustraction en adoptant des définitions des quantités renormalisées à des énergies caractéristiques variables, cela tout en maintenant fixe la théorie physique sous-jacente. À la limite où les masses d’un modèle deviennent négligeables, un changement d’échelle des impulsions peut être compensé par une variation des constantes de couplage et un facteur multiplicatif des champs, donc des fonctions de Green. Sous forme différentielle, on est conduit à une équation, due à Callan et Symanzik, dont l’élément essentiel est le flot de constante de couplage avec l’échelle d’énergie 猪:

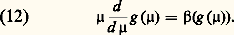

Le champ est susceptible de créer des particules correspondant aux solutions de fréquence positive des équations classiques ou d’en absorber ce qui correspond aux solutions de fréquence négative.Sous l’effet des interactions, les quanta ou particules peuvent être créés ou détruits, ou encore leur état interne modifié. Ces effets sont induits dans le lagrangien par des termes de degré supérieur à deux, soit symboliquement g .LI( 﨏). Dans un processus typique de diffusion, on peut imaginer que le rôle des interactions est négligeable longtemps avant ou après les collisions (théorie asymptotique de Harry Lehmann, Kurt Symanzik et Wolfgang Zimmermann). On utilise alors un formalisme, dit représentation d’interaction, dans lequel on donne aux opérateurs une évolution dictée par le lagrangien libre. L’amplitude de probabilité de transition entre un état entrant |in 礪 et sortant |out 礪, caractérisés entre autres par des ensembles de quadri-impulsionp, peut alors s’exprimer à l’aide de fonctions de Green dont l’étude est l’objet central de la théorie. D’une part, il est possible de chercher à exploiter leurs propriétés générales découlant de l’invariance relativiste, la causalité, c’est-à-dire la commutativité des observables pour des séparations du genre espace, l’unitarité ou conservation des probabilités et l’existence (ou l’absence) d’une énergie minimale non nulle pour les états distincts du vide. C’est le but de l’approche axiomatique qui aboutit à prouver des propriétés d’analyticité des amplitudes dans l’espace des impulsions. D’autre part, on peut procéder à un développement systématique dans la (les) constante(s) de couplage g .Développement perturbatif et renormalisationCe développement fait apparaître une série infinie de termes dont il est possible de donner une représentation par des diagrammes dus à Feynman. Chaque ligne porteuse d’une impulsion p est associée à un propagateur, et chaque vertex à une interaction comportant une constante de couplage et un facteur exprimant la conservation des quadriimpulsions. À impulsions externes fixées, il s’agit alors d’intégrer sur les impulsions internes restant indéterminées. Les termes correspondant à des diagrammes sans circuits fermés (diagrammes en arbres) sont dits termes de Born (termes de premier ordre) et leur évaluation ne pose pas de problèmes. En revanche, les contributions des termes plus élevés font en général apparaître des divergences pour les valeurs infinies des moments internes, qui sont dites ultraviolettes en souvenir des difficultés ultraviolettes dans le spectre du corps noir. L’origine de ces divergences tient au caractère singulier des propagateurs et à l’existence de couplages locaux, c’est-à-dire n’impliquant pas de structure interne dans une théorie fondamentale. En électrodynamique, par exemple, aucun signe d’une telle sous-structure n’a pu être mis en évidence jusqu’à des distances inférieures au millième de la taille des noyaux.Pour donner un sens à la série perturbative, il est donc nécessaire de trouver des prescriptions de soustraction qui conduisent à des intégrales bien définies. C’est un des triomphes de la théorie d’être parvenu à définir un schéma unique et cohérent de soustraction qui élimine les quantités apparemment infinies au profit d’observables, masses et charges des particules, et d’une redéfinition des champs au moyen de facteurs multiplicatifs. Ce processus est appelé renormalisation, et les modèles auxquels il s’applique sont dits renormalisables. En pratique, la méthode consiste à introduire à un stade intermédiaire une régularisation, caractérisée par un facteur de coupure 炙 ayant la dimension d’une énergie, et beaucoup plus grand que toutes les énergies mises en jeu dans le processus étudié. On classe alors le degré de divergence potentiel d’une contribution représentée par un diagramme ou sous-diagramme, et on caractérise les amplitudes primitivement divergentes. Dans une théorie renormalisable, ces amplitudes sont en nombre fini et, après soustraction, leurs divergences sont absorbées dans des quantités mesurables correspondantes. Bien entendu, la renormalisation préserve les propriétés fondamentales, en particulier l’invariance relativiste, et conduit à des expressions finies, bien que parfois malcommodes à évaluer. Pour donner une idée de cette complexité, mentionnons un calcul du moment anormal de l’électron à l’ordre 見4. Le nombre des diagrammes est de 891, et les amplitudes associées requièrent soustractions, intégrations multiples et manipulations algébriques.Une remarque importante due originellement à E.C.G. Stueckelberg et Alexander L. Peterman (1953) et à Gell-Mann et Low (1954) concerne l’existence d’un groupe de transformations, dit groupe de renormalisation. Il tire son origine de la possibilité d’effectuer les opérations de soustraction en adoptant des définitions des quantités renormalisées à des énergies caractéristiques variables, cela tout en maintenant fixe la théorie physique sous-jacente. À la limite où les masses d’un modèle deviennent négligeables, un changement d’échelle des impulsions peut être compensé par une variation des constantes de couplage et un facteur multiplicatif des champs, donc des fonctions de Green. Sous forme différentielle, on est conduit à une équation, due à Callan et Symanzik, dont l’élément essentiel est le flot de constante de couplage avec l’échelle d’énergie 猪: Les points fixes g c , tels que 廓 s’annule, peuvent être des attracteurs ultraviolets (ils sont alors tels que la pente de la fonction 廓 est négative au voisinage de g c ). Dans ce cas, la théorie asymptotique sera invariante d’échelle avec des comportements non triviaux si g c 0. Un cas important correspond à la situation où l’origine est un attracteur ultraviolet. Outre le fait qu’au voisinage de g = 0 on peut utiliser la théorie perturbative pour estimer 廓, il en résulte des propriétés remarquables, pour de telles théories qui sont dites asymptotiquement libres. Il est possible de pousser plus loin cette analyse du comportement à courte distance en effectuant des développements de produits d’opérateurs en termes de moins en moins singuliers.Électrodynamique quantiqueLe modèle des théories perturbatives est l’électrodynamique, cas où les calculs ont pu être menés le plus loin et confrontés à des expériences très précises. Parmi les processus étudiés, citons la diffusion élastique (effet Compton) ou inélastique (création de paires) des photons sur des cibles chargées, le rayonnement de freinage (bremsstrahlung ), la diffusion ou l’annihilation électron-positron... Les corrections radiatives aux processus de diffusion de particules chargées présentent des divergences infrarouges d’origine semi-classique. Le nombre de photons mous émis ou absorbés ne peut être borné. Pour obtenir des résultats finis significatifs, il faut alors tenir compte de la résolution expérimentale.En ce qui concerne la spectroscopie atomique, en particulier pour les systèmes hydrogénoïdes, on calcule les déplacements et les largeurs de raies à partir d’une première approximation fournie par l’équation de Dirac. La méthode suivie pour obtenir les corrections est due à Hans A. Bethe et Edwin E. Salpeter. Parmi les développements les plus significatifs, mentionnons d’abord le calcul du déplacement de Lamb des niveaux 2s -2p de l’atome d’hydrogène, qui joua un rôle historique, et dont la prédiction théorique et la valeur expérimentale s’accordent sur six chiffres:

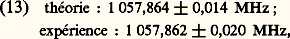

Les points fixes g c , tels que 廓 s’annule, peuvent être des attracteurs ultraviolets (ils sont alors tels que la pente de la fonction 廓 est négative au voisinage de g c ). Dans ce cas, la théorie asymptotique sera invariante d’échelle avec des comportements non triviaux si g c 0. Un cas important correspond à la situation où l’origine est un attracteur ultraviolet. Outre le fait qu’au voisinage de g = 0 on peut utiliser la théorie perturbative pour estimer 廓, il en résulte des propriétés remarquables, pour de telles théories qui sont dites asymptotiquement libres. Il est possible de pousser plus loin cette analyse du comportement à courte distance en effectuant des développements de produits d’opérateurs en termes de moins en moins singuliers.Électrodynamique quantiqueLe modèle des théories perturbatives est l’électrodynamique, cas où les calculs ont pu être menés le plus loin et confrontés à des expériences très précises. Parmi les processus étudiés, citons la diffusion élastique (effet Compton) ou inélastique (création de paires) des photons sur des cibles chargées, le rayonnement de freinage (bremsstrahlung ), la diffusion ou l’annihilation électron-positron... Les corrections radiatives aux processus de diffusion de particules chargées présentent des divergences infrarouges d’origine semi-classique. Le nombre de photons mous émis ou absorbés ne peut être borné. Pour obtenir des résultats finis significatifs, il faut alors tenir compte de la résolution expérimentale.En ce qui concerne la spectroscopie atomique, en particulier pour les systèmes hydrogénoïdes, on calcule les déplacements et les largeurs de raies à partir d’une première approximation fournie par l’équation de Dirac. La méthode suivie pour obtenir les corrections est due à Hans A. Bethe et Edwin E. Salpeter. Parmi les développements les plus significatifs, mentionnons d’abord le calcul du déplacement de Lamb des niveaux 2s -2p de l’atome d’hydrogène, qui joua un rôle historique, et dont la prédiction théorique et la valeur expérimentale s’accordent sur six chiffres: celui de la structure hyperfine et, parmi les quantités plus fondamentales, l’évaluation du moment magnétique anormal de l’électron ou du muon 猪.Le formalisme s’adapte aussi à la discussion des propriétés du rayonnement émis par des systèmes macroscopiques, tels le laser ou encore des effets fortement non linéaires, telles les transitions multiphotoniques observées dans les faisceaux de grande intensité. La théorie de la cohérence quantique due à Roy J. Glauber fait le pont avec les aspects purement classiques du rayonnement, tandis qu’il est possible de traiter dans un formalisme unique des phénomènes tel le rayonnement synchrotron dont l’importance pratique va grandissant.L’électrodynamique quantique se distingue de sa contrepartie classique par le rôle capital qu’y joue l’invariance de jauge. Il s’agit de la possibilité de modifier la phase des champs chargés d’une manière dépendant de l’espace et du temps, cette modification étant accompagnée par celle du quadripotentiel A size=1猪(x ).Si 祥(x ) désigne un champ chargé, on a:

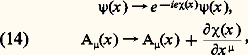

celui de la structure hyperfine et, parmi les quantités plus fondamentales, l’évaluation du moment magnétique anormal de l’électron ou du muon 猪.Le formalisme s’adapte aussi à la discussion des propriétés du rayonnement émis par des systèmes macroscopiques, tels le laser ou encore des effets fortement non linéaires, telles les transitions multiphotoniques observées dans les faisceaux de grande intensité. La théorie de la cohérence quantique due à Roy J. Glauber fait le pont avec les aspects purement classiques du rayonnement, tandis qu’il est possible de traiter dans un formalisme unique des phénomènes tel le rayonnement synchrotron dont l’importance pratique va grandissant.L’électrodynamique quantique se distingue de sa contrepartie classique par le rôle capital qu’y joue l’invariance de jauge. Il s’agit de la possibilité de modifier la phase des champs chargés d’une manière dépendant de l’espace et du temps, cette modification étant accompagnée par celle du quadripotentiel A size=1猪(x ).Si 祥(x ) désigne un champ chargé, on a: conduisant à la dérivation covariante des champs:

conduisant à la dérivation covariante des champs: Le remplacement des dérivées ordinaires par les dérivées covariantes constitue la prescription de couplage minimal. Ce principe est essentiel pour la quantification et la renormalisation, et il se traduit par des identités (John C. Ward-Yasushi Takahashi) qui relient des amplitudes différant par l’émission d’un photon.Champs de jauge non abéliensLe groupe des changements de phase est commutatif ou abélien (cf. GROUPES). En 1954, Yang et Mills suggérèrent d’étudier des systèmes possédant une invariance locale non abélienne. La modification remarquable, introduite par une telle généralisation, tient à ce que les quanta du champ de jauge analogues aux photons sont porteurs de nombres quantiques, comme le seraient des particules chargées. La théorie correspondante est de ce fait plus complexe à construire, et il a fallu près d’une dizaine d’années pour en établir correctement la quantification et les propriétés de renormalisation. Dans un modèle comportant un groupe local dont les générateurs hermitiques size=1見 satisfont aux règles de commutation d’une algèbre de Lie compacte [cf. ALGÈBRE]:

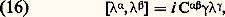

Le remplacement des dérivées ordinaires par les dérivées covariantes constitue la prescription de couplage minimal. Ce principe est essentiel pour la quantification et la renormalisation, et il se traduit par des identités (John C. Ward-Yasushi Takahashi) qui relient des amplitudes différant par l’émission d’un photon.Champs de jauge non abéliensLe groupe des changements de phase est commutatif ou abélien (cf. GROUPES). En 1954, Yang et Mills suggérèrent d’étudier des systèmes possédant une invariance locale non abélienne. La modification remarquable, introduite par une telle généralisation, tient à ce que les quanta du champ de jauge analogues aux photons sont porteurs de nombres quantiques, comme le seraient des particules chargées. La théorie correspondante est de ce fait plus complexe à construire, et il a fallu près d’une dizaine d’années pour en établir correctement la quantification et les propriétés de renormalisation. Dans un modèle comportant un groupe local dont les générateurs hermitiques size=1見 satisfont aux règles de commutation d’une algèbre de Lie compacte [cf. ALGÈBRE]: la différentiation covariante devient:

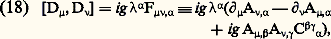

la différentiation covariante devient: impliquant une transformation infinitésimale dans l’espace interne, à laquelle sont associés les champs de jauge A size=1猪, size=1見(x ). L’intensité du champ reflète le caractère non abélien du groupe par la présence de termes quadratiques:

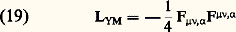

impliquant une transformation infinitésimale dans l’espace interne, à laquelle sont associés les champs de jauge A size=1猪, size=1見(x ). L’intensité du champ reflète le caractère non abélien du groupe par la présence de termes quadratiques: et le lagrangien de Yang-Mills:

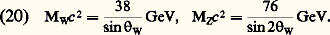

et le lagrangien de Yang-Mills: décrit apparemment des particules vectorielles de masse nulle en interaction.Selon les modes de couplage, le contenu physique d’une telle théorie peut en fait être très différent. Dans certains modèles, les champs de jauge sont couplés à des champs scalaire 﨏 dont les auto-interactions peuvent favoriser une brisure spontanée de la symétrie. Celle-ci s’accompagne de l’apparition d’une valeur moyenne non nulle du champ 麗 﨏 礪 dans l’état fondamental. Ce phénomène est analogue à l’apparition d’une aimantation spontanée dans un ferromagnétique au-dessous de la température de Curie. Si le groupe de symétrie G est continu, en l’absence de couplage aux champs de jauge, les états excités du système correspondant à des oscillations lentes de 麗 﨏 礪 auront une énergie arbitrairement faible. Les quanta associés sont dits modes de Jeffrey Goldstone. La situation est radicalement modifiée en présence des champs de jauge. Les modes mous du champ scalaire sont couplés aux quanta de jauge correspondant aux mêmes transformations de la valeur moyenne 麗 﨏 礪. La diagonalisation du propagateur matriciel associé fait apparaître des modes vectoriels massifs (phénomène de Higgs). Ce mécanisme avait en fait été découvert par Philip W. Anderson dans l’étude de la propagation d’un champ magnétique dans un supraconducteur où il limite la pénétration à une distance finie (effet Meissner). Seuls les quanta de jauge qui correspondent aux transformations laissant 麗 﨏 礪 invariant demeurent de masse nulle. Ce scénario est mis à profit dans le modèle unifié de Salam et Weinberg des interactions électromagnétiques et faibles. Le groupe de jauge SU(2) 憐 U(1) [le groupe U(N) est celui des matrices N 憐 N unitaires, SU(N) désigne le sous-groupe des matrices de déterminant unité] possède quatre générateurs auxquels sont associés quatre types de quanta. Trois d’entre eux donnent lieu à l’apparition de bosons vectoriels massifs W size=1梁 et Z0, médiateurs des interactions faibles, et un dernier correspond à des particules de masse nulle, qui ne sont autres que les photons. Le modèle est caractérisé par la constante de structure fine 見 et un angle W associé au découplage entre Z0 et photons. Le modèle prédit les masses des bosons massifs (observés au C.E.R.N en 1983) à des corrections radiatives près:

décrit apparemment des particules vectorielles de masse nulle en interaction.Selon les modes de couplage, le contenu physique d’une telle théorie peut en fait être très différent. Dans certains modèles, les champs de jauge sont couplés à des champs scalaire 﨏 dont les auto-interactions peuvent favoriser une brisure spontanée de la symétrie. Celle-ci s’accompagne de l’apparition d’une valeur moyenne non nulle du champ 麗 﨏 礪 dans l’état fondamental. Ce phénomène est analogue à l’apparition d’une aimantation spontanée dans un ferromagnétique au-dessous de la température de Curie. Si le groupe de symétrie G est continu, en l’absence de couplage aux champs de jauge, les états excités du système correspondant à des oscillations lentes de 麗 﨏 礪 auront une énergie arbitrairement faible. Les quanta associés sont dits modes de Jeffrey Goldstone. La situation est radicalement modifiée en présence des champs de jauge. Les modes mous du champ scalaire sont couplés aux quanta de jauge correspondant aux mêmes transformations de la valeur moyenne 麗 﨏 礪. La diagonalisation du propagateur matriciel associé fait apparaître des modes vectoriels massifs (phénomène de Higgs). Ce mécanisme avait en fait été découvert par Philip W. Anderson dans l’étude de la propagation d’un champ magnétique dans un supraconducteur où il limite la pénétration à une distance finie (effet Meissner). Seuls les quanta de jauge qui correspondent aux transformations laissant 麗 﨏 礪 invariant demeurent de masse nulle. Ce scénario est mis à profit dans le modèle unifié de Salam et Weinberg des interactions électromagnétiques et faibles. Le groupe de jauge SU(2) 憐 U(1) [le groupe U(N) est celui des matrices N 憐 N unitaires, SU(N) désigne le sous-groupe des matrices de déterminant unité] possède quatre générateurs auxquels sont associés quatre types de quanta. Trois d’entre eux donnent lieu à l’apparition de bosons vectoriels massifs W size=1梁 et Z0, médiateurs des interactions faibles, et un dernier correspond à des particules de masse nulle, qui ne sont autres que les photons. Le modèle est caractérisé par la constante de structure fine 見 et un angle W associé au découplage entre Z0 et photons. Le modèle prédit les masses des bosons massifs (observés au C.E.R.N en 1983) à des corrections radiatives près: Une étude expérimentale des prédictions de basse énergie, en particulier la mise en évidence des courants neutres faibles associés à l’existence du Z0, permet d’attribuer à W une valeur donnée par:

Une étude expérimentale des prédictions de basse énergie, en particulier la mise en évidence des courants neutres faibles associés à l’existence du Z0, permet d’attribuer à W une valeur donnée par: En l’absence de phénomène de Higgs, les conséquences dynamiques d’une invariance locale sont encore plus impressionnantes. Dans le cadre des méthodes perturbatives, on montre que seules de telles théories possèdent la propriété de liberté asymptotique. Le flot de constante de couplage décrit par la fonction 廓 [équation (12)] admet l’origine comme attracteur ultraviolet. La valeur effective du couplage relatif à des énergies de plus en plus grandes, ou des distances et temps relatifs de plus en plus courts, décroît vers zéro logarithmiquement:

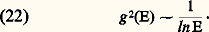

En l’absence de phénomène de Higgs, les conséquences dynamiques d’une invariance locale sont encore plus impressionnantes. Dans le cadre des méthodes perturbatives, on montre que seules de telles théories possèdent la propriété de liberté asymptotique. Le flot de constante de couplage décrit par la fonction 廓 [équation (12)] admet l’origine comme attracteur ultraviolet. La valeur effective du couplage relatif à des énergies de plus en plus grandes, ou des distances et temps relatifs de plus en plus courts, décroît vers zéro logarithmiquement: Des particules interagissant par l’intermédiaire de tels quanta apparaîtront essentiellement libres sur de courtes distances. Pour apprécier à quel point ce phénomène est inhabituel, on peut le rapprocher du cas en apparence analogue de l’électrodynamique. Une charge tend à polariser virtuellement le vide par création de paires. L’attraction entre charges opposées a tendance à diminuer la charge effective mesurée à grande distance. Cette image resterait vraie dans le cas non abélien si un effet dû aux auto-interactions des quanta du champ ne venait jouer en sens opposé. Cet effet l’emporte lorsque le nombre d’espèces chargées reste limité.ChromodynamiqueCette propriété remarquable sert de fondement à un modèle des hadrons, particules en interaction forte, comme états liés de quarks interagissant via les quanta d’un champ de jauge non abélien (les gluons). Le groupe correspondant est isomorphe à SU(3), et les degrés de liberté associés sont dits de couleur, ce qui a fait baptiser la théorie de chromodynamique. En bombardant des cibles à haute énergie et grand transfert d’impulsion par des faisceaux d’électrons, mésons 神 ou neutrinos, on constate que les nucléons possèdent une structure compatible avec l’existence de quarks de charge et nombre baryonique fractionnaire interagissant très faiblement à courte distance. Les prédictions concernant les déviations à un tel comportement sont en accord semi-quantitatif avec les observations.En contrepartie, la chromodynamique est caractérisée par un couplage de plus en plus fort à basse énergie. Dans ce domaine, les méthodes perturbatives deviennent inapplicables. On soupçonne que les forces deviennent suffisamment intenses pour interdire de séparer les constituants des hadrons. C’est le problème du confinement pour lequel il est nécessaire de trouver de nouvelles méthodes d’analyse.Intégrales de chemins et mécanique statistiqueÀ ce point, il faut faire un retour sur la nature des théories quantiques, en reprenant le fil d’un raisonnement esquissé par Dirac en 1933 et développé par Feynman et Kac. L’amplitude de probabilité de transition entre états caractérisés par des valeurs 﨏 des variables de configuration est donnée à la limite des temps très courts par un facteur de phase proportionnel à l’action classique:

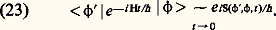

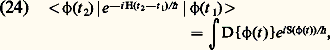

Des particules interagissant par l’intermédiaire de tels quanta apparaîtront essentiellement libres sur de courtes distances. Pour apprécier à quel point ce phénomène est inhabituel, on peut le rapprocher du cas en apparence analogue de l’électrodynamique. Une charge tend à polariser virtuellement le vide par création de paires. L’attraction entre charges opposées a tendance à diminuer la charge effective mesurée à grande distance. Cette image resterait vraie dans le cas non abélien si un effet dû aux auto-interactions des quanta du champ ne venait jouer en sens opposé. Cet effet l’emporte lorsque le nombre d’espèces chargées reste limité.ChromodynamiqueCette propriété remarquable sert de fondement à un modèle des hadrons, particules en interaction forte, comme états liés de quarks interagissant via les quanta d’un champ de jauge non abélien (les gluons). Le groupe correspondant est isomorphe à SU(3), et les degrés de liberté associés sont dits de couleur, ce qui a fait baptiser la théorie de chromodynamique. En bombardant des cibles à haute énergie et grand transfert d’impulsion par des faisceaux d’électrons, mésons 神 ou neutrinos, on constate que les nucléons possèdent une structure compatible avec l’existence de quarks de charge et nombre baryonique fractionnaire interagissant très faiblement à courte distance. Les prédictions concernant les déviations à un tel comportement sont en accord semi-quantitatif avec les observations.En contrepartie, la chromodynamique est caractérisée par un couplage de plus en plus fort à basse énergie. Dans ce domaine, les méthodes perturbatives deviennent inapplicables. On soupçonne que les forces deviennent suffisamment intenses pour interdire de séparer les constituants des hadrons. C’est le problème du confinement pour lequel il est nécessaire de trouver de nouvelles méthodes d’analyse.Intégrales de chemins et mécanique statistiqueÀ ce point, il faut faire un retour sur la nature des théories quantiques, en reprenant le fil d’un raisonnement esquissé par Dirac en 1933 et développé par Feynman et Kac. L’amplitude de probabilité de transition entre états caractérisés par des valeurs 﨏 des variables de configuration est donnée à la limite des temps très courts par un facteur de phase proportionnel à l’action classique: Pour obtenir l’expression relative à un intervalle de temps fini, il suffit d’appliquer le principe de superposition en subdivisant l’intervalle en fractions infinitésimales. À la limite, on obtient formellement une intégrale sur des variations arbitraires des variables de configuration 﨏(t ), que l’on écrit à une normalisation près:

Pour obtenir l’expression relative à un intervalle de temps fini, il suffit d’appliquer le principe de superposition en subdivisant l’intervalle en fractions infinitésimales. À la limite, on obtient formellement une intégrale sur des variations arbitraires des variables de configuration 﨏(t ), que l’on écrit à une normalisation près: avec des conditions aux limites 﨏(t )|t =t 1,2 = 﨏(t 1,2). Des intégrales fonctionnelles analogues avaient déjà été introduites en mathématiques par Paul Levy et Norbert Wiener.La relation entre mécanique quantique et mécanique classique est particulièrement bien en évidence. Cette dernière correspond, dans la limite 寮0, à l’évaluation de l’intégrale par la méthode des phases stationnaires. On retrouve ainsi le principe de moindre action, 嗀S = 0, définissant les trajectoires classiques. Une généralisation quantique est due à Julian Seymour Schwinger. Il existe une extension dans le cas de champs fermioniques, faisant appel à des variables anticommutantes (Feliks Aleksandrovich Bérézin).Dans la limite des petites fluctuations, il est possible d’évaluer ces intégrales par la méthode des phases stationnaires. Au voisinage d’une solution 﨏 rendant l’action extrémale, la contribution à l’intégrale s’écrira:

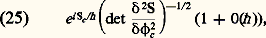

avec des conditions aux limites 﨏(t )|t =t 1,2 = 﨏(t 1,2). Des intégrales fonctionnelles analogues avaient déjà été introduites en mathématiques par Paul Levy et Norbert Wiener.La relation entre mécanique quantique et mécanique classique est particulièrement bien en évidence. Cette dernière correspond, dans la limite 寮0, à l’évaluation de l’intégrale par la méthode des phases stationnaires. On retrouve ainsi le principe de moindre action, 嗀S = 0, définissant les trajectoires classiques. Une généralisation quantique est due à Julian Seymour Schwinger. Il existe une extension dans le cas de champs fermioniques, faisant appel à des variables anticommutantes (Feliks Aleksandrovich Bérézin).Dans la limite des petites fluctuations, il est possible d’évaluer ces intégrales par la méthode des phases stationnaires. Au voisinage d’une solution 﨏 rendant l’action extrémale, la contribution à l’intégrale s’écrira: où les termes d’ordre 寮n peuvent être systématiquement étudiés.Cette formulation se prête commodément à la discussion de la quantification dans le cas de modèles à symétrie locale. L’action étant invariante, l’intégrale telle qu’on l’a présentée contient des facteurs infinis qu’il s’agira de factoriser de manière invariante. Ne désirant conserver qu’un seul représentant dans chaque classe de champs déduits les uns des autres par une transformation de jauge, on introduit une condition supplémentaire associée à un facteur Jacobien nécessaire pour maintenir l’invariance. L’analyse du résultat conduit à des règles perturbatives modifiées.Une extension naturelle engendre la théorie euclidienne des champs. Il s’agit d’une rotation dans le plan complexe de la variable temps t漣it . Le facteur oscillant comprenant l’action dite minkowskienne se transforme en une expression réelle selon:

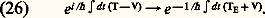

où les termes d’ordre 寮n peuvent être systématiquement étudiés.Cette formulation se prête commodément à la discussion de la quantification dans le cas de modèles à symétrie locale. L’action étant invariante, l’intégrale telle qu’on l’a présentée contient des facteurs infinis qu’il s’agira de factoriser de manière invariante. Ne désirant conserver qu’un seul représentant dans chaque classe de champs déduits les uns des autres par une transformation de jauge, on introduit une condition supplémentaire associée à un facteur Jacobien nécessaire pour maintenir l’invariance. L’analyse du résultat conduit à des règles perturbatives modifiées.Une extension naturelle engendre la théorie euclidienne des champs. Il s’agit d’une rotation dans le plan complexe de la variable temps t漣it . Le facteur oscillant comprenant l’action dite minkowskienne se transforme en une expression réelle selon: Les termes cinétiques, quadratiques dans les vitesses, changent de signe dans cette transformation.L’intégrale fonctionnelle qui décrivait une amplitude de transition quantique devient alors semblable à une fonction de partition, en mécanique statistique classique. La température est proportionnelle à 寮 et l’énergie des configurations est remplacée par l’action euclidienne. La mécanique relativiste quantique s’identifie dans ce prolongement à une théorie stochastique de champs classiques, distribués à l’équilibre avec une loi de probabilité donnée par le facteur de Boltzmann:

Les termes cinétiques, quadratiques dans les vitesses, changent de signe dans cette transformation.L’intégrale fonctionnelle qui décrivait une amplitude de transition quantique devient alors semblable à une fonction de partition, en mécanique statistique classique. La température est proportionnelle à 寮 et l’énergie des configurations est remplacée par l’action euclidienne. La mécanique relativiste quantique s’identifie dans ce prolongement à une théorie stochastique de champs classiques, distribués à l’équilibre avec une loi de probabilité donnée par le facteur de Boltzmann: Cette rotation à des temps imaginaires purs, conçue simultanément comme un prolongement sur les variables conjuguées (énergies), ne modifie en rien les techniques développées dans le cas minkowskien. Elle ouvre au contraire d’intéressantes possibilités en éclairant réciproquement les deux sujets: physique des particules et mécanique statistique, auxquels s’appliquent les mêmes outils. Cette analogie apporte à la théorie des champs les ressources et les méthodes des modèles statistiques, en particulier la notion de transition de phase et les propriétés d’universalité des phénomènes critiques qui y sont observées. À la mécanique statistique, elle offre les techniques développées dans l’étude des théories des champs. L’extension des idées du groupe de renormalisation a entraîné ainsi une révolution dans le calcul des comportements critiques.La question du confinement en chromodynamique peut être formulée dans le cadre de l’analogie statistique. On introduit une régularisation ultraviolette à l’aide d’un réseau spatio-temporel. Il est alors possible d’engendrer des développements de couplage fort (semblables aux développements de haute température) qui font apparaître l’existence d’un potentiel confinant (croissant linéairement avec la séparation) entre charges colorées statiques. D’importants progrès ont été effectués dans le traitement purement numérique des intégrales qui portent sur des nombres importants de variables, en utilisant les capacités des gros ordinateurs.La généralisation des théories locales aux cordes quantiques a nécéssité le développement de nouveaux outils: invariance conforme, représentations d’algèbres de Lie infinies. Parmi les résultats les plus marquants, citons l’élucidation des transitions de phases en deux dimensions (Belavin, Polyakov, Zamolodchikov), la possibilité d’inclure dans un même schéma quantique l’ensemble des interactions, y compris la gravitation, et des applications à la topologie (Witten) comme les invariants des nœuds ou des variétés de basse dimension.En poussant la dynamique quantique relativiste à ses extrêmes, les théories des champs se heurteront probablement à de nouveaux problèmes conceptuels, dont l’intégration de la gravitation dans le schéma quantique est un exemple. Déjà, le rôle de l’astrophysique et des questions cosmologiques suscite un intérêt passionnant. De ce fait, la théorie des champs est loin d’être un sujet clos.

Cette rotation à des temps imaginaires purs, conçue simultanément comme un prolongement sur les variables conjuguées (énergies), ne modifie en rien les techniques développées dans le cas minkowskien. Elle ouvre au contraire d’intéressantes possibilités en éclairant réciproquement les deux sujets: physique des particules et mécanique statistique, auxquels s’appliquent les mêmes outils. Cette analogie apporte à la théorie des champs les ressources et les méthodes des modèles statistiques, en particulier la notion de transition de phase et les propriétés d’universalité des phénomènes critiques qui y sont observées. À la mécanique statistique, elle offre les techniques développées dans l’étude des théories des champs. L’extension des idées du groupe de renormalisation a entraîné ainsi une révolution dans le calcul des comportements critiques.La question du confinement en chromodynamique peut être formulée dans le cadre de l’analogie statistique. On introduit une régularisation ultraviolette à l’aide d’un réseau spatio-temporel. Il est alors possible d’engendrer des développements de couplage fort (semblables aux développements de haute température) qui font apparaître l’existence d’un potentiel confinant (croissant linéairement avec la séparation) entre charges colorées statiques. D’importants progrès ont été effectués dans le traitement purement numérique des intégrales qui portent sur des nombres importants de variables, en utilisant les capacités des gros ordinateurs.La généralisation des théories locales aux cordes quantiques a nécéssité le développement de nouveaux outils: invariance conforme, représentations d’algèbres de Lie infinies. Parmi les résultats les plus marquants, citons l’élucidation des transitions de phases en deux dimensions (Belavin, Polyakov, Zamolodchikov), la possibilité d’inclure dans un même schéma quantique l’ensemble des interactions, y compris la gravitation, et des applications à la topologie (Witten) comme les invariants des nœuds ou des variétés de basse dimension.En poussant la dynamique quantique relativiste à ses extrêmes, les théories des champs se heurteront probablement à de nouveaux problèmes conceptuels, dont l’intégration de la gravitation dans le schéma quantique est un exemple. Déjà, le rôle de l’astrophysique et des questions cosmologiques suscite un intérêt passionnant. De ce fait, la théorie des champs est loin d’être un sujet clos.

Encyclopédie Universelle. 2012.